Por el contrario, sólo el 8% de los entrevistados considera que las mujeres podrían ser víctimas de discriminación por parte de la IA. Ahora bien, es importante tener en cuenta que estos datos reflejan percepciones y no necesariamente la realidad objetiva de la discriminación por parte de la IA.

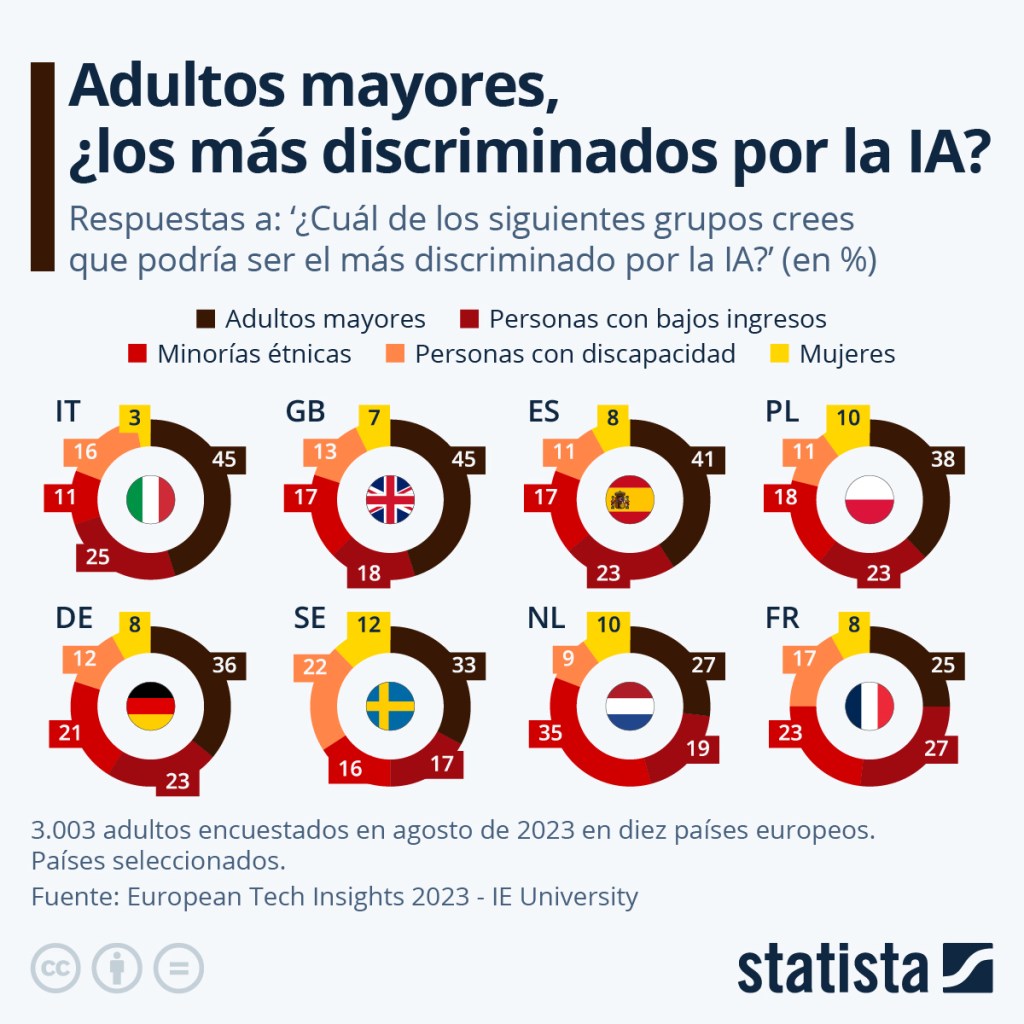

En agosto de este año, como parte del estudio “European Tech Insights”, se preguntó a más de 3.000 entrevistados en diez países europeos acerca de los sectores que creían que podrían llegar a ser más discriminados por la inteligencia artificial generativa.

Desde la empresa aclararon que el objetivo de la pregunta fue el de “discernir qué grupos demográficos se perciben como más discriminados” por la IA y “la pregunta se estructuró para permitir una amplia gama de interpretaciones”. Por ejemplo, algunos encuestados podrían haber tenido en mente aspectos más concretos posiblemente asociados al hardware, como el acceso a los programas de inteligencia artificial, “que afecta predominantemente a las generaciones de más edad”.

Por otro lado, otros entrevistados “podrían haber considerado la discriminación algorítmica: las respuestas pueden amplificar los sesgos inherentes a los datos en línea, la fuente principal de la IA generativa. Por ejemplo, la búsqueda de la palabra “CEO” en Midjourney produce imágenes de hombres blancos, mientras que la búsqueda de ‘autista’ da como resultado imágenes de niños pelirrojos”.

Además, agregan desde la compañía responsable del informe que las personas que contestaron la pregunta podrían haber tenido también en cuenta el hecho de que “algunos chatbots podrían incorporar y propagar contenido sesgado existente en sus respuestas”.